在AI技术飞速渗透各行业核心领域的当下,其伴生的安全风险已不再是理论推演,而是悬在数字化转型头顶的达摩克利斯之剑。数据泄露、算法偏见、模型窃取、恶意滥用等威胁层出不穷。在此背景下,AI安全风险监测平台应运而生,它如同智能时代的“数字免疫系统”,对AI系统进行全天候、多维度的健康“体检”与风险“预警”。其核心功能构成如下:

1. 风险识别与态势感知:全域扫描的“预警雷达”

模型脆弱性探测:自动扫描模型,检测是否存在对抗样本攻击漏洞、数据中毒隐患、后门植入风险、成员推理攻击等结构性弱点。

数据风险监控:实时监控训练、推理数据的流动与存储状态。识别敏感数据未脱敏或意外暴露;检测训练数据分布偏移或特征漂移,即实际应用数据与训练数据差异过大导致模型性能骤降;发现数据投毒攻击痕迹。

算法公平性审计:运用公平性指标持续评估模型在不同人群子集上的决策差异,量化并可视化偏见程度,揭示可能存在的歧视性输出。

系统及供应链安全扫描:检查AI运行环境配置安全;分析依赖的第三方库、框架、预训练模型是否含有已知漏洞或恶意代码,防范供应链攻击。

2. 实时监控与异常检测:永不疲倦的“安全哨兵”

行为基线建模:基于历史正常运行数据,利用机器学习建立模型“健康”行为基线。

动态异常告警:实时对比当前行为与基线,运用统计过程控制、孤立森林、自编码器等技术,识别异常推理请求、异常输出、性能陡降或资源异常消耗。

威胁情报集成:对接外部威胁情报源,将平台监控与全球威胁动态关联,提升对新型攻击的检测能力。

3. 深度分析溯源与取证:精准定位的“数字侦探”

攻击链重构:当检测到异常或攻击事件时,平台聚合日志、模型快照、输入输出数据、网络流量等多源信息,可视化展示攻击路径,明确攻击入口点和影响范围。

根本原因分析:结合脆弱性扫描结果与实时监控数据,定位问题根源。例如,模型性能下降是源于数据漂移、对抗攻击,还是底层计算资源故障?偏见加剧是否由特定新数据引入?

取证与报告:生成结构化、可审计的事件报告,详细记录攻击特征、影响模型、涉及数据、时间线、取证证据链,满足事后调查、责任厘清和合规汇报需求。

4. 联动响应与防御加固:主动闭环的“安全中枢”

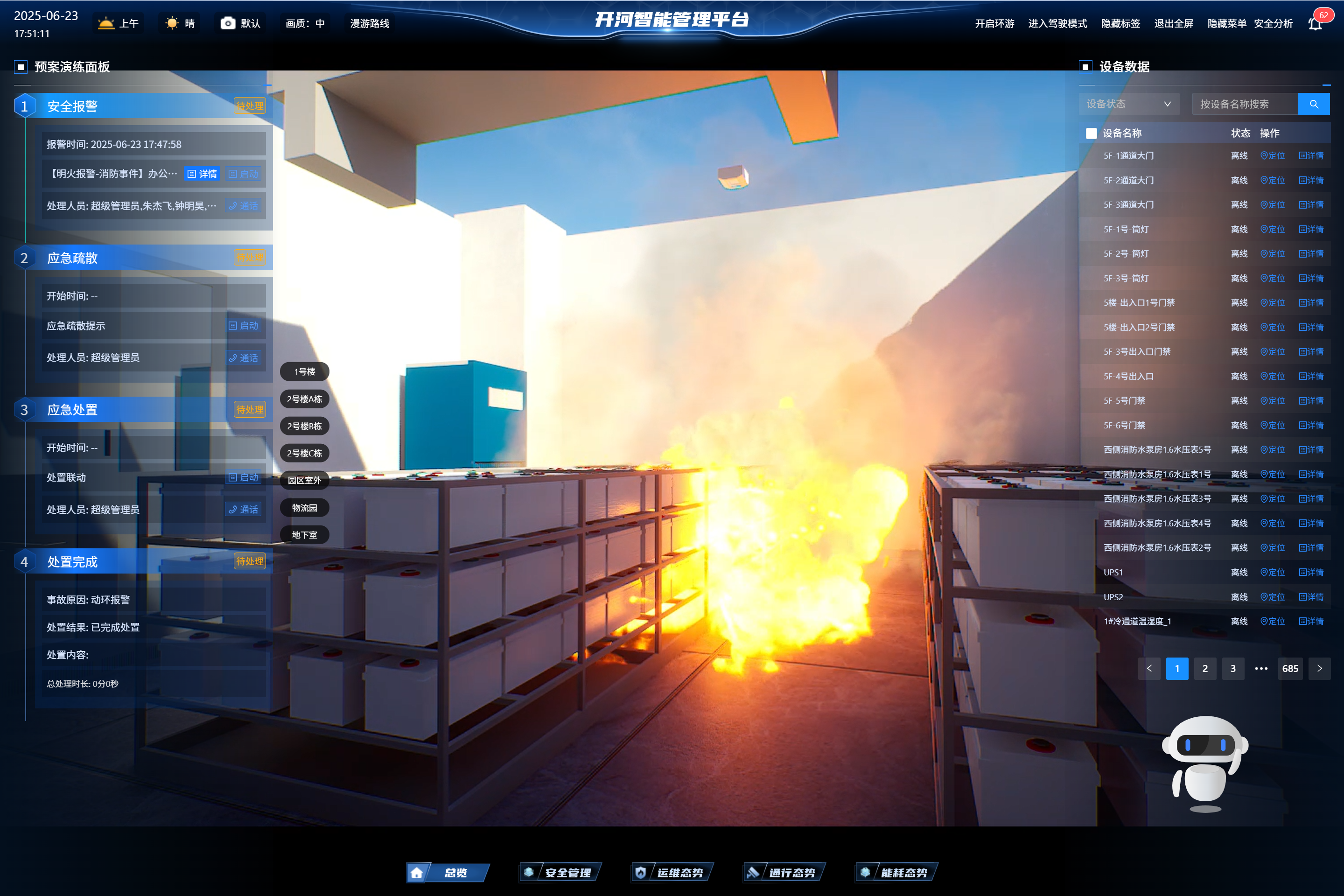

自动化响应编排:预定义响应剧本。当检测到高风险事件,可自动触发:隔离受污染数据批次、临时下线受影响模型版本、通知安全运维人员、阻断恶意源IP、启动模型重训练流程等动作,缩短响应时间。

模型加固建议:基于识别的脆弱性,提供针对性的加固方案建议,如推荐采用对抗训练、防御性蒸馏、输入预处理过滤等技术。

策略优化反馈:将监测分析结果反馈给模型开发和安全策略制定团队,指导模型设计优化、数据治理策略调整、安全防护规则更新,形成持续改进闭环。

5. 合规审计与可视化治理:透明的“责任仪表盘”

合规性检查:内置或可配置符合主要法规标准的检查清单。自动化评估模型在透明度、可解释性、数据隐私、人权影响等方面是否符合要求,生成合规差距报告。

审计追踪:完整记录所有模型从开发、测试、部署到运行监控、更新的全生命周期操作日志、配置变更、数据使用情况、访问控制事件,确保可追溯、不可篡改。

全局风险可视化:通过集中式仪表盘,直观展示组织内所有AI资产的实时安全状态、风险分布(按模型类型、业务线、风险等级)、合规态势、告警趋势、处置进度等关键信息,赋能管理层全局决策。

AI安全风险监测平台绝非简单的告警工具,它通过深度融合风险识别、实时监控、深度分析、联动响应与合规治理五大核心能力,构建了一套覆盖AI全生命周期的“感知-认知-决策-行动”闭环体系。其价值在于将AI安全从传统的“事后救火”模式,转变为“事前预警、事中控制、事后溯源加固”的主动免疫模式。